全新A100采用HBM2e技术,可将A100 40GB GPU的高带宽内存增加一倍至80GB,提供每秒超过2TB的内存带宽。这使得数据可以快速传输到全球最快的数据中心GPU A100上,使研究人员能够更快地加速其应用,处理最大规模的模型和数据集。 NVIDIA应用深度学习研究副总裁Bryan Catanzaro表示:“若想获得HPC和AI的最新研究成果,则需要构建最大的模型,而这需要比以往更大的内存容量和更高的带宽。A100 80GB GPU所提供的内存是六个月前推出的前代产品的两倍,突破了每秒2TB的限制,使研究人员可以应对全球科学及大数据方面最严峻的挑战。” 用于NVIDIA DGXTM A100 和NVIDIA DGX StationTM A100 系统的NVIDIA A100 80GB GPU也于今日发布,预计将于本季度发货。 领先的系统提供商源讯、戴尔科技、富士通、技嘉科技、慧与、浪潮、联想、云达科技、超微预计将于2021年上半年,提供基于HGX A100集成底板的系统,该集成底板搭载4-8个A100 80GB GPU。 满足大流量数据工作负载需求 A100 80GB版本基于A100 40GB的多样化功能,成为需要大量数据存储空间的各类应用的理想选择。 DLRM等推荐系统模型为AI训练提供了涵盖数十亿用户和产品信息的海量表单。A100 80GB可实现高达3倍加速,使企业可以重新快速训练这些模型,从而提供更加精确的推荐。 HGX服务器中搭载的A100 80GB还可训练具有更多参数的最大模型,如GPT-2。GPT-2是具有超常生成文本能力的自然语言处理模型。这就消除了对数据或模型并行架构的需求,因为实现并行架构需要花费大量时间,而且跨多个节点运行缓慢。 凭借其多实例GPU(MIG)技术,A100可分割为多达7个GPU实例,每个实例具有10GB内存。该技术是一种安全的硬件隔离方法,在处理各类较小的工作负载时,可实现GPU最佳利用率。对于如RNN-T等自动语言识别模型的AI推理,单个A100 80GB MIG实例可处理更大规模的批量数据,将生产中的推理吞吐量提高1.25倍。 在TB级零售大数据分析基准上,A100 80GB将其性能提高了2倍,使其成为可对最大规模数据集进行快速分析的理想平台。随着数据的动态更新,企业可以实时做出关键决策。 对于科学应用,A100 80GB可为天气预报和量子化学等领域提供巨大的加速。材料模拟软件Quantum Espresso采用单节点A100 80GB实现了近2倍的吞吐量提升。 RIKEN计算科学中心负责人Satoshi Matsuoka表示:“快速、充足的内存带宽和容量对实现高性能超级计算应用来说至关重要。具有80GB HBM2e GPU内存的NVIDIA A100提供2TB/s的全球最快带宽,可帮助我们大幅提高应用性能。” A100 80GB的关键特性 A100 80GB具备NVIDIA Ampere架构突破性特性: ●第三代Tensor Core核心:通过全新TF32,将上一代Volta架构的AI吞吐量提高多达20倍。通过FP64,将HPC性能提高多达2.5倍。通过 INT8,将AI推理性能提高多达20倍,并且支持BF16数据格式。 ●更大、更快的HBM2e GPU内存:使内存容量增加一倍,在业内率先实现2TB/s以上的内存带宽。 ●MIG技术:将单个独立实例的内存增加一倍,可最多提供七个MIG,每个实例具备10GB内存。 ●结构化稀疏:将推理稀疏模型的速度提高2倍。 ●第三代NVlink和NVSwitch,相较于上一代互连技术,可使GPU之间的带宽增加至原来的两倍,将数据密集型工作负载的GPU数据传输速度提高至每秒600 gigabytes。 NVIDIA HGX AI 超级计算平台 A100 80GB GPU是NVIDIA HGX AI超级计算平台的关键组件。该平台将NVIDIA GPU、NVIDIA NVlink® 、NVIDIA InfiniBand网络以及全面优化的NVIDIA AI和HPC软件堆栈的全部功能整合在一起,以提供最优越的应用性能。该平台使研究人员和科学家能够将HPC、数据分析和深度学习计算技术结合起来,共同推动科学进步。

铁锚

铁锚 大桥

大桥 金桥

金桥 京雷

京雷 天泰

天泰 博威合金BOWAY

博威合金BOWAY 马扎克Mazak

马扎克Mazak 威尔泰克

威尔泰克 迈格泰克

迈格泰克 斯巴特

斯巴特 MAOSHENG贸盛

MAOSHENG贸盛 Miller米勒

Miller米勒 新世纪焊接

新世纪焊接 西安恒立

西安恒立 上海特焊

上海特焊 新天激光

新天激光 海目星激光

海目星激光 迅镭激光

迅镭激光 粤铭YUEMING

粤铭YUEMING 镭鸣Leiming

镭鸣Leiming 领创激光

领创激光 天琪激光

天琪激光 亚威Yawei

亚威Yawei 邦德激光bodor

邦德激光bodor 扬力YANGLI

扬力YANGLI 宏山激光

宏山激光 楚天激光

楚天激光 百超迪能NED

百超迪能NED 金运激光

金运激光 LVD

LVD Tanaka田中

Tanaka田中 BLM

BLM 易特流etal

易特流etal 百盛激光

百盛激光 Messer梅塞尔

Messer梅塞尔 PrimaPower普玛宝

PrimaPower普玛宝 全自动焊接流水线

全自动焊接流水线 上海通用电气 全焊机系列展示

上海通用电气 全焊机系列展示 松下 旗下LAPRISS机器人激光焊接系统

松下 旗下LAPRISS机器人激光焊接系统 KUKA 库卡摩多机器人流水线作业

KUKA 库卡摩多机器人流水线作业 大焊 焊机匠心品质 精工之作 行家之选

大焊 焊机匠心品质 精工之作 行家之选 川崎工业焊接机器人 焊接管架

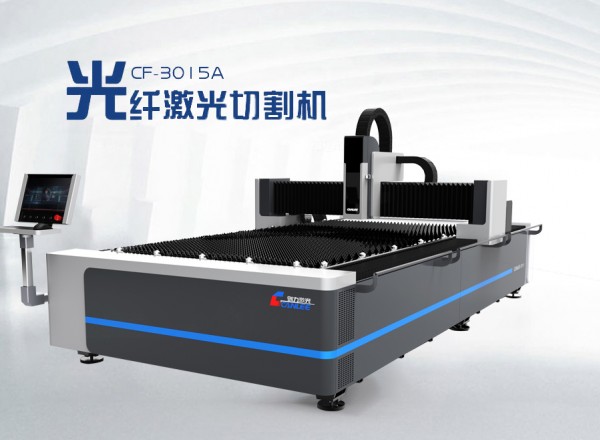

川崎工业焊接机器人 焊接管架 创力 CANLEE光纤激光切割机

创力 CANLEE光纤激光切割机 供应下展式放料阀厂家批发价格

供应下展式放料阀厂家批发价格 康道昊威数控多关节机器人 6轴机器人 机械手 焊接机器人

康道昊威数控多关节机器人 6轴机器人 机械手 焊接机器人 ABB IRB-2400 焊接机器人焊接机器人、码垛机器人

ABB IRB-2400 焊接机器人焊接机器人、码垛机器人 MegaTec迈格泰克NB-270(广东联洋科技有限公司)

MegaTec迈格泰克NB-270(广东联洋科技有限公司) 供应逆变交直流脉冲氩弧焊机

供应逆变交直流脉冲氩弧焊机 250A柴油发电电焊机 发电电焊机 250A 190A

250A柴油发电电焊机 发电电焊机 250A 190A 直流氩弧焊机

直流氩弧焊机 厂家热销座式焊接变位机/重型焊接变位机/轻型焊接变位机

厂家热销座式焊接变位机/重型焊接变位机/轻型焊接变位机